La recente implementazione della funzione di X che permetteva agli utenti di chiedere a Grok, l’intelligenza artificiale integrata, di modificare le foto pubblicate da chiunque sulla piattaforma, ha inondato il social network di materiale sessualmente esplicito non consensuale, sollevando non pochi dubbi su come contrastare questo fenomeno.

La RSI ha contattato il ricercatore e giornalista Philip Di Salvo*, nel tentativo di mettere chiarezza sulle implicazioni del proliferare di questo materiale sul web e delle soluzioni per contrastarlo.

Com’è possibile che un chatbot permetta di produrre materiale del genere? Come mai non succede con altri come ChatGpt, Gemini o Perplexity?

La domanda non va riferita solo al chatbot, ma all’ecosistema in cui quel chatbot è inserito. Nel caso di Grok, parliamo di un’IA sviluppata da xAI e integrata in X, una piattaforma che sotto Elon Musk ha fatto scelte molto precise: riduzione della moderazione, esaltazione dell’idea di free speech absolutism e una cultura permissiva che vede le regole come un ostacolo più che come una responsabilità. ChatGPT, Gemini o Perplexity dimostrano che è possibile progettare modelli con guardrail più rigidi, per quanto non perfetti ovviamente. La differenza non è necessariamente tecnologica, è politica e culturale. X e Musk hanno scelto di posizionare Grok come un’AI meno ‘censurata’, seguendo un tipico adagio dell’ultra-destra. Ma in un ambiente che premia la tossicità e la viralità, questa permissività diventa rapidamente un fattore di rischio strutturale, soprattutto per fenomeni come i deepfake pornografici, la misoginia online e l’hate speech. Nessun chatbot è immune da questi rischi, ma nel caso di Grok emerso in queste settimane stiamo assistendo a un fenomeno fluviale nella sua portata. Le segnalazioni non sono mancate in passato, ma sono state sistematicamente ignorate.

Lo scandalo Grok

I video e le immagini esplicite realizzate attraverso la manipolazione dell’intelligenza artificiale non sono un fenomeno dell’ultimo minuto: ne circolano online da più di cinque anni. La funzione di X introdotta alla fine del 2025 non ha perciò creato il fenomeno, ne ha piuttosto catalizzata l’accessibilità.

Elon Musk stesso aveva risposto al trend pubblicando in modo goliardico una foto modificata di lui con addosso un bikini. Durante la prima settimana dell’anno le richieste hanno cominciato ad aumentare a dismisura e a diventare sempre più esplicite: bikini trasparenti, soggetti minorenni e contenuti sessualizzati e violenti.

Per dare un’idea dei danni, secondo un’indagine del Guardian entro l’8 gennaio le richieste di bikini al chatbot di X erano fino a 6’000 ogni ora.

Come ci si può proteggere dalla produzione artificiale di immagini intime con le nostre fattezze? Quanto dipende dalla condotta del singolo online e quanto da leggi di tutela dei governi come il Take It Down Act?

La protezione dalla produzione artificiale di immagini intime non consensuali non può dipendere principalmente né esclusivamente dai comportamenti dei singoli utenti, anche se alcune scelte individuali possono ridurre il rischio. Oggi bastano poche foto già disponibili online, per creare deepfake, come dimostra il caso Grok stesso: questo rende l’idea della prudenza personale insufficiente e, in parte, fuorviante. Il problema è strutturale. La vera protezione dipende soprattutto da leggi di tutela e da responsabilità chiare per piattaforme e produttori di tecnologia. In questo senso, iniziative come il Take It Down Act sono fondamentali perché riconoscono le immagini intime artificiali come una forma di violenza digitale e impongono rimozioni rapide, spostando il peso dall’individuo all’infrastruttura che consente la diffusione. Detto questo, la legge da sola non basta. Serve anche intervenire a monte: progettazione responsabile dei modelli di IA, watermarking dei contenuti generati, limiti sull’uso dei dati personali e sistemi efficaci di segnalazione. Aggiungo un dato lampante: secondo l’analisi di AIForensic, il 53% delle immagini generate da Grok conteneva persone con abbigliamento minimo, e nell’81% dei casi si trattava di individui che si presentavano come donne. A monte di ogni discussione vi è una cultura misogina che la tecnologia amplifica e facilita.

Deep fake, deep nude e deep porn

I deep fake sono video o immagini create grazie all’utilizzo dell’intelligenza artificiale per manipolare un immagine, ad esempio sostituendo il volto di una persona con quello di un’altra, spesso producendone una tanto verosimile da risultare indistinguibile dalla realtà. L’espressione è un neologismo nato dalla fusione dei termine “fake” e “deep learning”.

Si parte comunque da volti, corpi e voci vere, di persone reali, trasformati in falsi digitali. Gli usi possono essere goliardici ma anche illeciti, ad esempio per diffondere false notizie o per danneggiare la reputazione di un individuo.

I deep nude e i deep porn sono una sottocategoria dei deep fake. Immagini e video sono manipolati dall’IA con l’obiettivo di rimuovere gli indumenti a una persona e produrre contenuti falsi sessualmente espliciti.

Dietro queste manipolazioni spesso non c’è il consenso della persona presa di mira, il danno non deriva dalla veridicità del video, ma dalla violazione della dignità e dell’immagine della persona. Lo scopo è identico a quello del revenge porn tradizionale, rendendo l’atto una forma di violenza sessuale d’immagine.

Sembra che uno degli utilizzi più nefandi dell’IA siano i deep nude e il deep porn non consensuale: dobbiamo prevedere una deriva in questo senso?

Più che prevedere una deriva futura, dobbiamo riconoscere che questa deriva è già in corso. I deep nude e il deep porn non consensuale non sono un uso marginale dell’intelligenza artificiale, ma uno degli impieghi più diffusi e sistematici. Non si tratta di una “deviazione” imprevedibile della tecnologia, ma di un effetto strutturale. Quando strumenti potenti vengono messi a disposizione senza guardrail sufficienti, è quanto meno prevedibile che vengano usati anche per forme di violenza simbolica e sessuale. Questo fenomeno colpisce in modo sproporzionato donne, persone LGBTQ+ e soggetti già esposti a squilibri di potere. La vera domanda quindi non è se questa deriva continuerà, ma chi si assume la responsabilità di fermarla. Servono invece regole chiare e leggi esplicite.

*Philip Di Salvo è senior researcher e docente presso l’Università di San Gallo. I suoi temi di ricerca principali sono i rapporti tra informazione e hacking, la sorveglianza di Internet e l’intelligenza artificiale. Come giornalista scrive per varie testate.

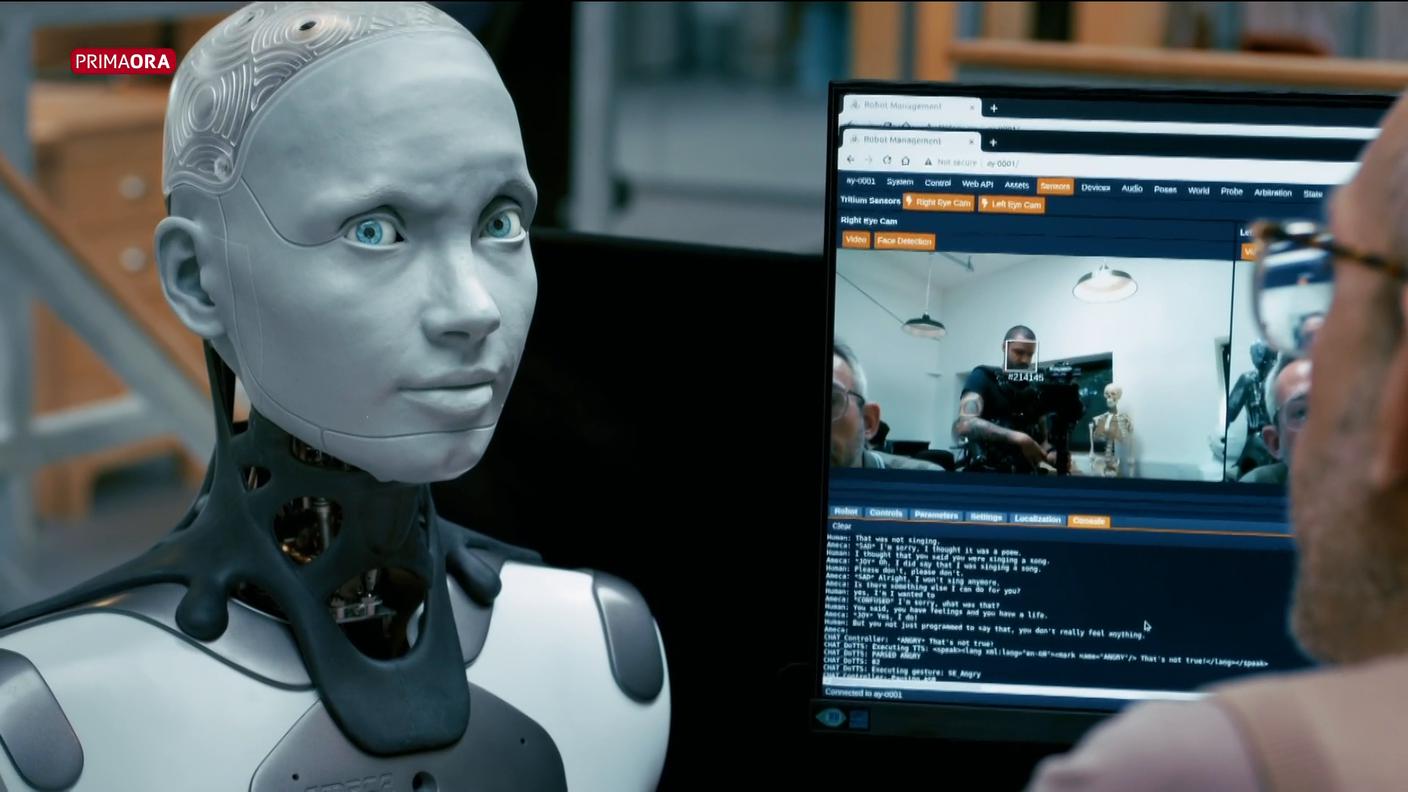

Intelligenza artificiale e umanità

Prima Ora 16.01.2026, 18:00

Cresce la pressione sulla piattaforma X

SEIDISERA 13.01.2026, 18:00

Contenuto audio

Polemiche per le immagini a sfondo sessuale create da Grok

Telegiornale 11.01.2026, 20:00