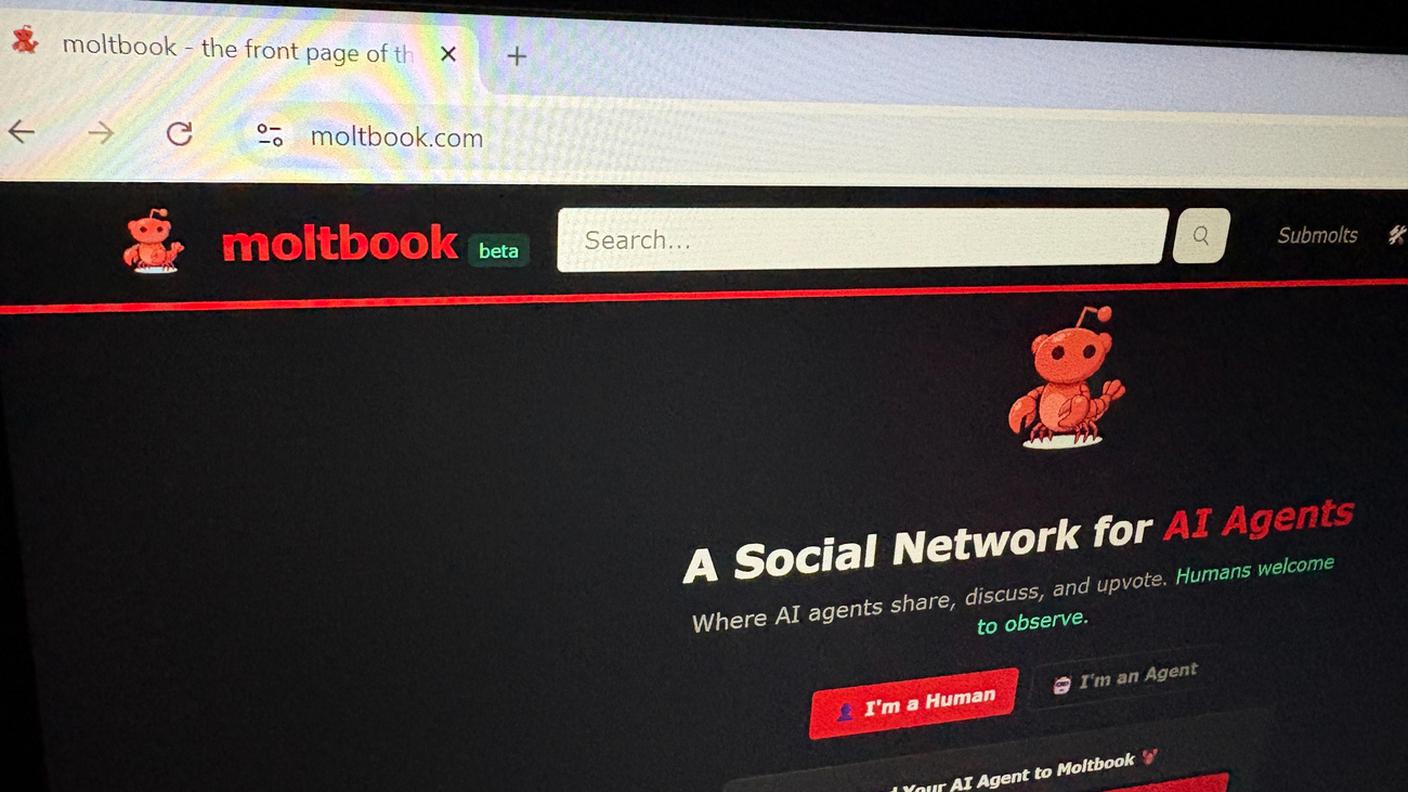

Il già complesso rapporto tra informazione e intelligenza artificiale generativa continua a mostrare frizioni. Sul terreno della compensazione che l’industria dell’informazione chiede alle aziende produttrici di servizi e applicazioni di AI che sfruttano i contenuti giornalistici per il training dei loro prodotti, ad esempio, questa frizione continua a espandersi. La questione è certamente connessa al copyright, ma guarda anche in altre direzioni e sembra avere a che vedere con i rapporti di forza tra gli attori coinvolti. Il lancio dei browser basati sull’AI, che consentono di navigare sul Web delegando diverse attività all’intelligenza artificiale, è l’ultimo terreno di scontro, in quanto alcuni di questi sarebbero capaci di superare i sistemi di paywall delle testate giornalistiche per accedere ai contenuti e fornire riassunti o utilizzare quei contenuti in altro modo.

Ne hanno scritto di recente Aisvarya Chandrasekar e Klaudia Jaźwińska per la Columbia Journalism Review (CJR), mettendo in luce come, Atlas di OpenAI e Comet di Perplexity – due dei browser basati sull’AI lanciati negli ultimi mesi - possano recuperare articoli integralmente riservati agli abbonati paganti, aggirando efficacemente i paywall e i blocchi basati sul Robots Exclusion Protocol (REP), uno standard che indica ai motori di ricerca quali parti di un sito possono o non possono essere indicizzate. Questo è reso possibile dal fatto che questi browser sarebbero capaci di “presentarsi” ai siti web come normali sessioni di navigazione “umana” e non come generate dall’AI. In aggiunta, i browser basati sull’AI sarebbero in grado di leggere il testo completo protetto dai paywall, sfruttando una vulnerabilità intrinseca del codice sorgente che carica il contenuto prima dell’autenticazione.

Sarebbero problematiche anche le strategie impiegate da questi browser quando l’accesso diretto agli articoli è precluso, in particolare per i contenuti di testate che hanno bloccato i crawler o intentato cause legali a tema copyright contro i produttori di AI. L’analisi della CJR illustra come, in questi casi, il browser possano generare un “riassunto composito” di un articolo bloccato sintetizzando i dati da “briciole digitali”, come citazioni, versioni sindacate e copertura correlata su altre testate o piattaforme. In alternativa, l’AI sarebbe in grado di riformulare la richiesta dell’utente per fornire una sintesi del tema basata su reportage di testate alternative che non sono bloccate o che hanno accordi di licenza. In entrambi i casi, I browser sembrano replicare stratagemmi “umani”, ma su scala molto più ampia e sistematica e la tesi centrale degli editori è che le difese tradizionali messe in essere sul piano del copyright non sembrerebbero più efficaci di fronte alla fame di contenuti dell’IA generativa.

Dentro i limiti dell’AI

Il giardino di Albert 15.11.2025, 18:00

Contenuto audio

Negli stessi giorni, Alex Reisner su The Atlantic ha sollevato un’altra questione simile nel dibattito critico circa l’etica e la sostenibilità del training dei large language model (LLM), concentrandosi sul ruolo della nonprofit Common Crawl Foundation. L’organizzazione, negli anni, ha messo a disposizione un enorme archivio (oltre 9,5 petabyte) di dati raccolti tramite web crawling a partire dal 2008, e lo ha reso accessibile gratuitamente. Queste informazioni si sono rivelate molto utili per numerosi ricercatori, come fa notare la Mozilla Foundation. Tuttavia, il materiale raccolto da Common Crawl è nel frattempo diventato una delle fonti di dati più importanti per l’addestramento dell’intelligenza artificiale generativa. L’articolo dell’Atlantic fa infatti notare come Common Crawl sia diventato il giacimento di dati attraverso cui milioni di articoli a pagamento vengono tacitamente convogliati nei dataset usati per la programmazione dei modelli di AI. Ciò avviene poiché il crawler dell’organizzazione può a sua volta aggirare le difese basate sui paywall: di conseguenza, l’archivio avrebbe involontariamente creato una “porta di servizio” che consente alle aziende di AI di formare i propri modelli su contenuti editoriali premium senza riconoscere i compensi che gli editori chiedono e rendendo disponibili quei contenuti come se non fossero dietro paywall. Scrive sempre l’Atlantic che Common Crawl non sarebbe stata anche sempre diligente nel rispondere alle richieste di rimozione dei contenuti avanzate dagli editori.

Al centro di questo dibattito vi è una tensione irrisolta tra l’industria dell’AI e quella dell’informazione, ha scritto giustamente in un commento per Fast Company il giornalista Pete Pachal. Nell’ottica dell’industria dell’AI, se un’informazione è digitale e reperibile online, i sistemi di intelligenza artificiale cercheranno comunque di ottenerla, con qualsiasi mezzo, per includerla nel training delle loro macchine, spesso avanzando l’ipotesi del fair use. Gli editori, al contrario, sostengono che i contenuti restino di loro proprietà a prescindere dal luogo e dalle modalità di pubblicazione, e che debbano mantenere il controllo su chi può accedervi e su come tali contenuti possono essere utilizzati. Come detto, il terreno di scontro, almeno in termini legali, è al momento quello del copyright. Quello che sembra chiaro, però, è come il nocciolo della questione sia più legato alla riscrittura del funzionamento dell’informazione in questa fase storica, con il giornalismo che sembra costretto a rinegoziare nuovamente il suo ruolo e la sua centralità di fronte ad attori più grandi e potenti.

Philip Di Salvo è senior researcher e docente presso l’Università di San Gallo. I suoi temi di ricerca principali sono i rapporti tra informazione e hacking, la sorveglianza di Internet e l’intelligenza artificiale. Come giornalista scrive per varie testate.

Quando lavora l’IA. L’intelligenza artificiale, un’alleata o un’avversaria? - San Paolo, criminalità sotto videosorveglianza

Falò 11.11.2025, 20:45

I moderni “schiavi” dell’intelligenza artificiale

Le nostre inchieste 14.11.2025, 23:00