“Sono un annotatore, lavoro sui loro dati, loro guadagnano milioni. Perché non possono fare in modo che io viva dignitosamente? Devono davvero sacrificarmi per la loro crescita?” Seduto in un vecchio grattacielo di Nairobi, Michael Geoffrey piange. L’uomo ha lavorato per anni come annotatore nel campo dell’intelligenza artificiale (IA). Il suo mestiere consisteva nell’addestrare algoritmi affinché diventassero efficienti. Un sistema che lo ha distrutto.

Lontano dagli scintillanti uffici della Silicon Valley, il Kenya è uno dei centri internazionali per i compiti più ingrati legati all’IA. Piccole imprese, ma anche giganti come Meta, ChatGPT, Tesla o TikTok vi delocalizzano una parte considerevole di questo lavoro invisibile ma essenziale per il funzionamento dell’IA generativa.

Un intervento umano “indispensabile”

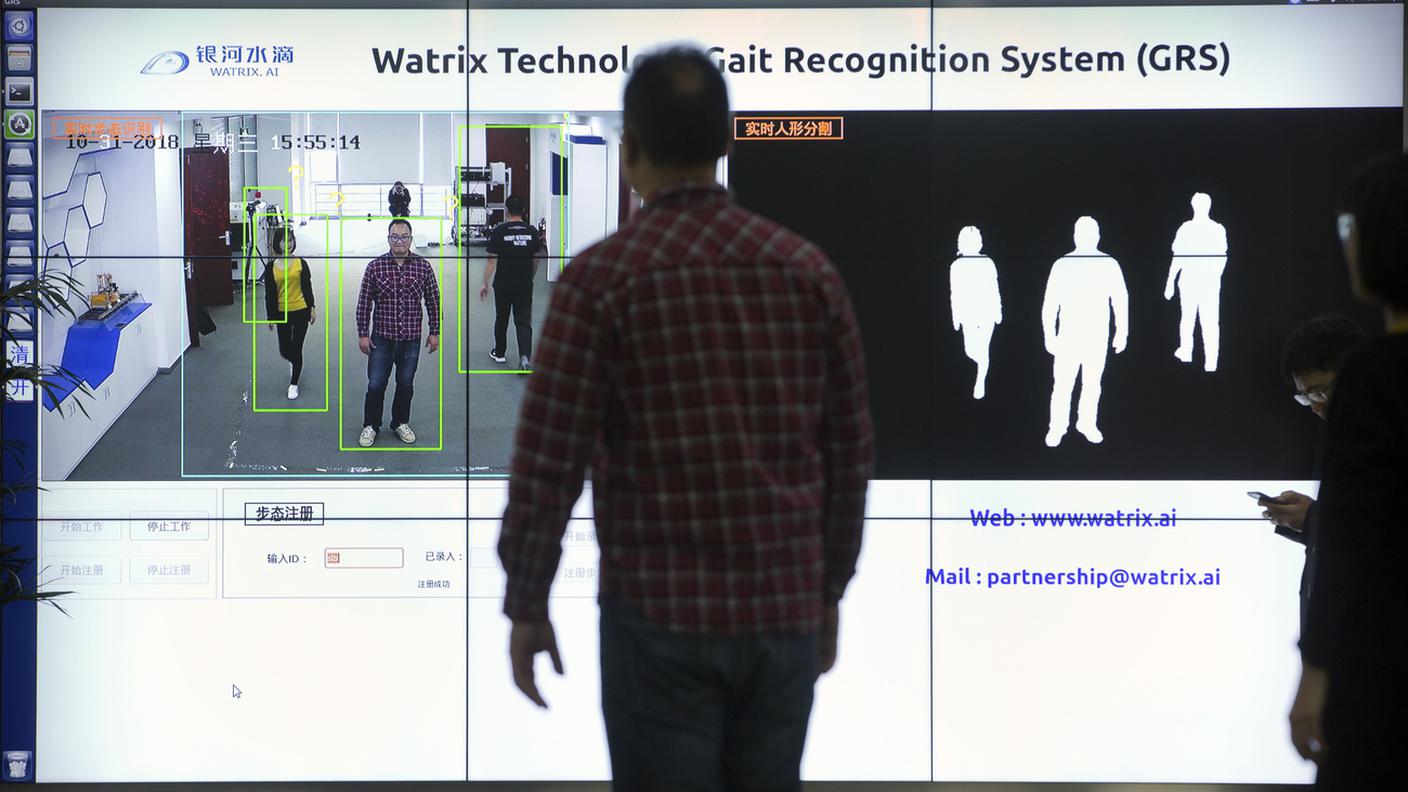

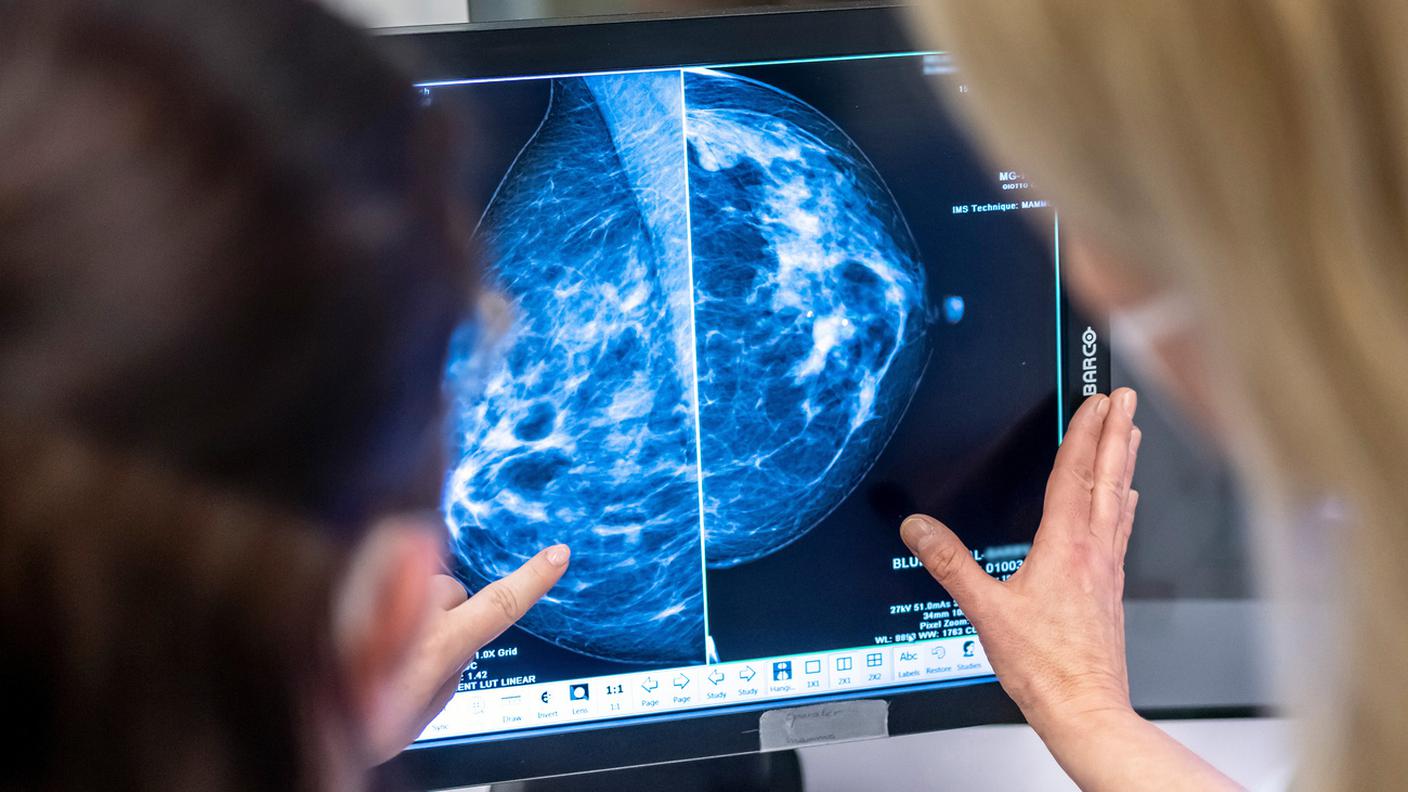

Tra questi compiti, c’è il lavoro di etichettare migliaia di immagini per identificare, ad esempio, le parti della testa di un cane, analizzare, immagine per immagine, tutti gli elementi ripresi da un veicolo o insegnare a un robot chirurgico come appaiono tagli e punti di sutura. Il principio è sempre lo stesso: affinché un’intelligenza artificiale sappia riconoscere un gatto, è necessario che degli esseri umani descrivano migliaia di foto di gatti.

Una logica che si applica anche ai chatbot come ChatGPT. “Ci sono molte persone pagate per porre buone domande (prompt) a ChatGPT, e altre che scrivono le risposte a queste domande”, spiega da Losanna il professor Robert West. Lo specialista ha appena concluso un anno di ricerca nei laboratori di Microsoft, negli Stati Uniti, uno dei centri mondiali dell’intelligenza artificiale generativa.

Precisa che questo gioco di domande e risposte non avviene in tempo reale e riguarda solo una minima parte delle possibili domande, ma è una fase essenziale per “educare” questi strumenti. “Senza intervento umano, sarebbe una catastrofe (…) Su internet ci sono molti contenuti che non vogliamo che ChatGPT ripeta: estremismo, teorie del complotto, ecc. Bisogna quindi addomesticare il modello”.

Dietro le quinte dell’IA (A bon entendeur, RTS, 04.11.2025)

Impatto sulla vita privata

Il direttore del Data Science Lab del Politecnico di Losanna sottolinea l’importanza cruciale di questi contributi umani, anche se il loro volume resta un segreto ben custodito: “Se dovessi fare una stima, direi che gli annotatori e i redattori di prompt investono più tempo degli ingegneri e dei programmatori” nello sviluppo di questi strumenti.

Si tratta di un’attività faticosa e spesso mal retribuita. In Kenya, molti annotatori sono costretti a cumulare più impieghi e a lavorare oltre 15 ore al giorno. È quanto è accaduto a Michael Geoffrey.

Per mantenere la sua famiglia, accetta ogni incarico che gli viene proposto. Così, per mesi, si ritrova ad annotare materiale pornografico per otto ore al giorno, oltre a un altro lavoro a tempo pieno. “Guardare pornografia per otto ore non è affatto uno scherzo. Dopo quattro o cinque giorni, il mio corpo si è completamente spento”. L’uomo non riesce più ad avere rapporti intimi con la moglie, e la coppia entra in crisi. “Ha distrutto la relazione. Alla fine ci siamo separati” confida ai microfoni di RTS.

Condizioni di lavoro indegne

Angela Chukunzira, sociologa presso la fondazione Mozilla, denuncia le condizioni di lavoro indegne di molti annotatori e i gravi rischi per la salute mentale. “Quando i lavoratori sono esposti in modo permanente a contenuti molto nocivi, diventano insensibili. Alcuni di loro perdono la propria umanità. E anche il loro senso della realtà risulta fortemente alterato” sottolinea la ricercatrice.

Gli annotatori non sono gli unici esposti a questi contenuti tossici. In prima linea c’è un altro gruppo di lavoratori invisibili dell’IA: i moderatori di contenuti impiegati dai social network. Su TikTok, ad esempio, l’85% dei contenuti inappropriati viene filtrato dall’intelligenza artificiale, ma l’intervento umano resta indispensabile per correggere i suoi errori.

Impiegato da un subappaltatore del colosso cinese a Nairobi, Ethan (nome di fantasia) è incaricato di individuare contenuti inappropriati provenienti da tutto il mondo. Almeno 250 video al giorno, tra cui immagini estremamente scioccanti pubblicate dagli utenti del social.

“La maggior parte dei video che vediamo su TikTok sono selezionati dall’intelligenza artificiale. Ma l’IA non è perfetta. Per esempio, non riesce a distinguere tra una persona che fuma una sigaretta e una con un lecca-lecca in bocca”. Una mancanza di affidabilità che può avere conseguenze gravi, a seconda della natura dei contenuti.

“La gente vede solo ciò che è bello”

“Nei video c’è di tutto: suicidi, torture, persone bruciate vive, pedopornografia… La gente normalmente vede solo ciò che è bello, come persone che ballano. Ma non sa che ci sono persone come me che filtrano i contenuti peggiori, a costo della propria salute mentale”, racconta.

“Alcuni video, due o tre, ti perseguitano per tutta la vita. Come quello di quei tre uomini con dei coltelli in mano che stavano smembrando una persona viva… capisci? È questo il tipo di cose che vediamo”.

Per questi lavoratori precari è difficile difendere i propri diritti e interessi nei confronti delle aziende da cui dipendono. Tanto più che i giganti della tecnologia si affidano a intermediari e non li assumono direttamente.

Un modello basato sullo sfruttamento

In questo difficile contesto, Mercy Mutemi è una delle alleate più preziose per questi lavoratori. Avvocata nella capitale keniota, conduce diverse azioni legali contro Meta, società madre di Facebook, Instagram e WhatsApp. “In Kenya, il settore dell’intelligenza artificiale, per quanto riguarda l’annotazione dei dati, la moderazione dei contenuti e l’addestramento degli algoritmi, si basa su un modello di sfruttamento che implica due cose: tratta di esseri umani o lavoro forzato”.

Le accuse, estremamente gravi, prendono di mira direttamente il colosso statunitense. “Meta stessa era coinvolta nella tratta di esseri umani (...) La piattaforma impone obiettivi irraggiungibili, per svolgere un lavoro impossibile che non si è nemmeno accettato volontariamente. E se non si raggiungono quegli obiettivi, il salario viene ridotto”.

Dipendenti vulnerabili

Numerosi migranti con uno status fragile hanno lavorato per Meta in Kenya, attraverso un sistema di subappalto. “L’intero schema consisteva nel far arrivare persone vulnerabili con modalità ingannevoli per poi sfruttarle. Ed è proprio questo che costituisce la tratta di esseri umani”. I casi sono attualmente pendenti davanti alla giustizia keniota.

Michael Geoffrey, da parte sua, oggi si batte per far valere i diritti dei suoi colleghi all’interno della DLA, Data Labelers Association, un giovane movimento di tipo sindacale che cerca di unire i piccoli per ottenere condizioni migliori dai grandi.

Meta, TikTok, OpenAI e Tesla non hanno risposto alle richieste di commento da parte della RTS.

Lavori precari anche in Svizzera

Per sei mesi anche Daniel Burnier ha scritto prompt le relative risposte da casa sua ad Aubonne., tramite la piattaforma Outlier. L’obiettivo era di addestrare strumenti simili a ChatGPT seguendo due istruzioni ben precise: essere creativi e molto locali. Un lavoro che permette ai chatbot di “parlare romando” con gli utenti della regione.

Così ha scritto domande e risposte sull’autore Maurice Chappaz, la Dent de Vaulion, le specialità culinarie ginevrine o ancora sul comune di Aubonne.

Dottore in Scienze sociali, è la precarietà ad averlo spinto verso questa attività. “Ero docente all’Università di Neuchâtel, ma il mio incarico non bastava a pagare le bollette. Così ho cercato di integrare il mio reddito entrando nel mondo dell’intelligenza artificiale”. Outlier recluta attivamente in Svizzera, e lui si è candidato tramite LinkedIn. Entra così nella rete di esperti di questo colosso globale del business dell’annotazione, Meta ha appena investito 14 miliardi di dollari nella sua casa madre. Un lavoro stimolante, ma dal quale non riesce a vivere.

“In Europa, sulla carta, si può guadagnare fino a 25 euro l’ora, ma in realtà c’è una brutta sorpresa per i lavoratori: non vengono garantite abbastanza mansioni per raggiungere un livello di retribuzione adeguato”, spiega Antonio Casilli, professore all’Institut Polytechnique di Parigi e specialista del settore.

Di fatto, Daniel Burnier aspetta invano che gli vengano assegnate nuove mansioni. Ma queste sono rare, e il livello di retribuzione oraria non corrisponde a quanto dichiarato. “La piattaforma non pagava il tempo che impiegavo per fare ricerche utili a scrivere buone risposte, né per seguire le formazioni obbligatorie per partecipare ai progetti. Ho guadagnato circa 500 franchi al mese per attività che occupavano circa il 30% del mio tempo”, quindi tra gli 8 e i 9 franchi l’ora.

Contattata, Outlier spiega che “il livello di retribuzione si basa su fattori come la complessità dei compiti, l’esperienza e la durata stimata per completarli” e che “la remunerazione è spesso competitiva rispetto al mercato per questo tipo di lavoro”.

IA: intervista a Giancarlo De Cataldo

Telegiornale 08.11.2025, 20:00